Люди правда тупеют от использования ИИ? Можно ли это предотвратить?

Да, мы тупеем, но мы счастливы. Разве мы не заслужили немного счастья? Мы будем рвать на себе волосы, когда наступит даунтайм чат-бота или блэкаут, но это будет не сегодня.

Курсовые работы и дипломы, которые за студентов пишет искусственный интеллект, — уже не новость, а обыденное положений вещей. В скольких областях ИИ массово применяется в рабочих целях — и не перечислить: от дизайна и журналистики (мы, журналисты, и сами уже не уверены в собственном существовании — вдруг мы просто функции матрицы и всегда такими были?) до медицины и кулинарии (ах, эти знаменитые рецепты нейросырников). Изначально было очевидно, что это оставит след на интеллекте человечества — осталось только понять его масштабы. Что происходит с мозгом человека, который делегирует сложные творческие задачи искусственному интеллекту? Уж не растут его извилины от этого точно, сообщает наука.

Использование генеративных языковых моделей, таких как ChatGPT, негативно влияет нейронную активность, память и креативность пользователя, показало исследование ученых из Массачусетского технологического института. В своем эксперименте они задались вопросом, как такие генеративные ИИ-инструменты влияют на когнитивные показатели студентов во время придумывания и сочинения учебных текстов.

Исследование называется «Ваш мозг на ChatGPT: накопление когнитивного долга при использовании ИИ-ассистента для написания эссе». В нем принимали участие 54 студента, чья мозговая активность отслеживалась посредством высокоплотной ЭЭГ.

Когнитивным долгом называют такое состояние, когда человек отказывается от самостоятельных размышлений, делегируя их искусственному интеллекту и получая от него готовые ответы. При этом настоящего понимания, почему эти ответы именно такие, а не другие, у пользователя нет — он «взял в долг» их у машины, не обладая никаким собственным когнитивным капиталом.

Чем выше наш когнитивный долг, который накапливается при многократном использовании ИИ, то есть чем сильнее зависимость от генеративных инструментов, тем ниже способность нашего мозга кодировать, извлекать и синтезировать информацию.

С повсеместным распространением больших генеративных языковых моделей все больше людей становятся когнитивными должниками. В особенности это заметно в сфере образования, где школьники и студенты сдают контрольные, курсовые и дипломы, целиком написанные ИИ.

Логично предположить, что в дальнейшем такая тенденция можно привести к полному интеллектуальному банкротству, когда большинство задач, прежде решавшихся специалистами, будут отданы на откуп машинам.

Но дело в том, что машины в производстве эффективных решений опираются на данные, которые стали продуктом многолетнего упорного труда миллионов умных людей.

Если эта база проверенных и качественных данных, которым можно доверять, не будет наращиваться когнитивно разными людьми, машины с их ошибками и отсутствием лапок для контакта с реальным миром ради проверки их гипотез, могут нагенерить нам полной чуши. Как в меме про робота, который оперировал аппендицит не с той стороны, а потом жизнерадостно просил прощения за ошибку и требовал новой попытки. Но вернемся к исследованию.

В рамках опыта участников разделили на три группы: одна называлась «Только мозг» и не пользовалась вспомогательными инструментами вовсе, другой было разрешено гуглить информацию, третьи клепали текст с помощью GPT-4o. У всех было четыре сессии, в ходе которых они писали эссе, пока их мозговая активность изучалась.

При этом на финальной сессии метод изменился: учащиеся, которые начали с ChatGPT, должны были закончить писать без него, а тем, кто начинал писать самостоятельно, наоборот, разрешили воспользоваться ИИ.

Студенты, которые не прибегали ни к каким цифровым инструментам, отличались самой высокой фронтально-теменной и семантической коннективностью — этот показатель демонстрирует уровень исполнительных функций и глубокой обработки памяти.

У тех же, кто с самого начала полагался на ChatGPT, была самая низкая коннективность, особенно в альфа- и бета-диапазонах ЭЭГ. Перейдя от взаимодействия с ИИ к самостоятельному написанию эссе, эти студенты испытывали постоянные трудности при попытке вспомнить и процитировать, что именно они написали. Что неудивительно, учитывая, что сами они не написали ничего — фактически вся их работа была взята в долг у языковой модели.

«Люди уже страдают от этого, но многие все еще пытаются отрицать, что использование ChatGPT изменяет то, как мы концентрируемся, творим и оцениваем», — прокомментировал эти результаты коллега исследователей, нейроученый Дзюн-Тын Йе, занимающийся острой проблемой этических рамок для ИИ в медицине.

Одним из наиболее любопытных выводов исследования стало значение того, на каком этапе работы стоит прибегать к языковым моделям, если уж обойтись без них не получается.

78% студентов из группы Brain-to-LLM, которые начинали без ИИ и только под конец стали использовать его для редактирования и дополнения уже написанного, правильно вспоминали и цитировали свои тексты даже на финальных стадиях, а также отличались более высокой мозговой связностью (хоть и не такой высокой, как в группе «Только мозг»).

И наоборот, участники группы LLM-to-Brain, то есть переключившиеся с ИИ на самостоятельную работу, испытывали трудности с активацией тех же самых нейронных сетей, что приводило, по словам исследователей, к «лингвистически пресным» эссе. В 78% случаев они не могли правильно вспомнить, о чем в них шла речь.

Хотя тексты, созданные с помощью ИИ, получали высокие оценки как от людей, так и от других искусственных интеллектов, им не хватало разнообразия идей и личной вовлеченности автора, отсутствие которой бросалось в глаза.

Студенты из группы LLM-to-Brain на протяжении текста многократно мусолили одни и те же темы без их критического и вариативного осмысления, что ставит под вопрос, насколько они вообще поняли и усвоили материал, а также их личную креативность — то есть все то, что в принципе оценивается преподавателями и ради чего оценка существует.

Исследователи заключили, что зависимость от генеративного ИИ, в особенности на ранних этапах работы, снижает способность учащихся производить и усваивать новые идеи, критически оценивать информацию, а также значительно ухудшает память. Согласно данным ЭЭГ, такие студенты слишком сильно перекладывают умственную работу на инструмент и не производят самостоятельных когнитивных усилий.

Измерения также показывают снижение метакогнитивной активности, особенно в областях мозга, отвечающих за мониторинг ошибок и самооценку.

«Если начинать с собственных идей и лишь затем обращаться за помощью к ИИ, у нас еще есть возможность сохранить полноценную работу нейронных цепей.

Однако использование ИИ с самого начала ослабляет нейронные пути, отвечающие за креативность и критическое мышление», — сказал Дзюн-Тын Йе.

Понятно, что исследования взаимоотношений человека с языковыми моделями и их долгосрочное влияние на человеческий мозг должны продолжаться. Но уже из имеющихся сейчас данных можно сделать резонный практический вывод: чтобы сохранить то, что ученые называют когнитивной агентностью, то есть уникальную способность человека познавать и творить, при этом не становясь неолуддитом и пользуясь в своей работе преимуществами новейших цифровых инструментов, необходимо следовать четкому гибридному подходу, то есть чередовать фазы работы без ИИ и с ним.

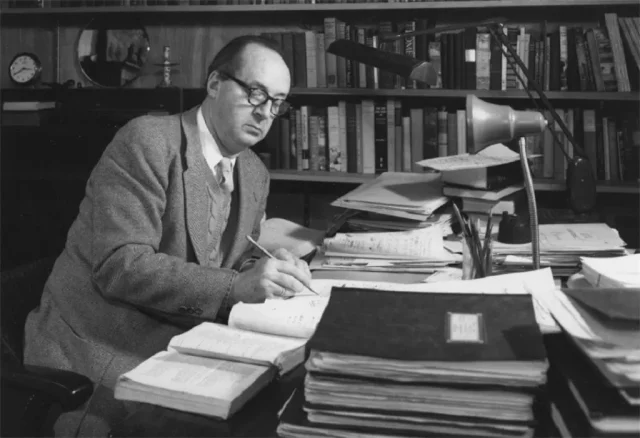

При этом начинать творческую работу, какой бы она ни была, следует по старинке — один на один со своими неоформившимися идеями и боязнью пустого листа, полагаясь только на себя в этой самой тяжелой части пути. Только так вы не задолжаете свои последние нейроны шайтан-программе и получите результат, которым сможете действительно гордиться и без зазрения совести называть своим собственным.

У вас есть коллеги, подсевшие на на ChatGPT или похожие языковые модели? Поделитесь с ним этим материалом — возможно, им стоит пересмотреть принципы своего сотрудничества с цифровым помощником!